- Introduction

현재, computer vision model 들은 single modal 에 대하여 굉장히 잘 작동함

그러나 사람과 같이 modal 에 대한 flexibility 를 가지지 못함

► Modality-agnostic model 의 필요성

Modality-agnostic model 의 장점

- Cross-modal generalization: 한 가지 modality 에서 배운 정보를 다른 modality 의 recognition 에 활용할 수 있음

- Saves the research and engineering effort: 너무 당연함

- Leverage new visual sensors

이런 장점들에도 불구하고 다양한 문제(capacity)들로 인해 연구가 거의 되지 않았음

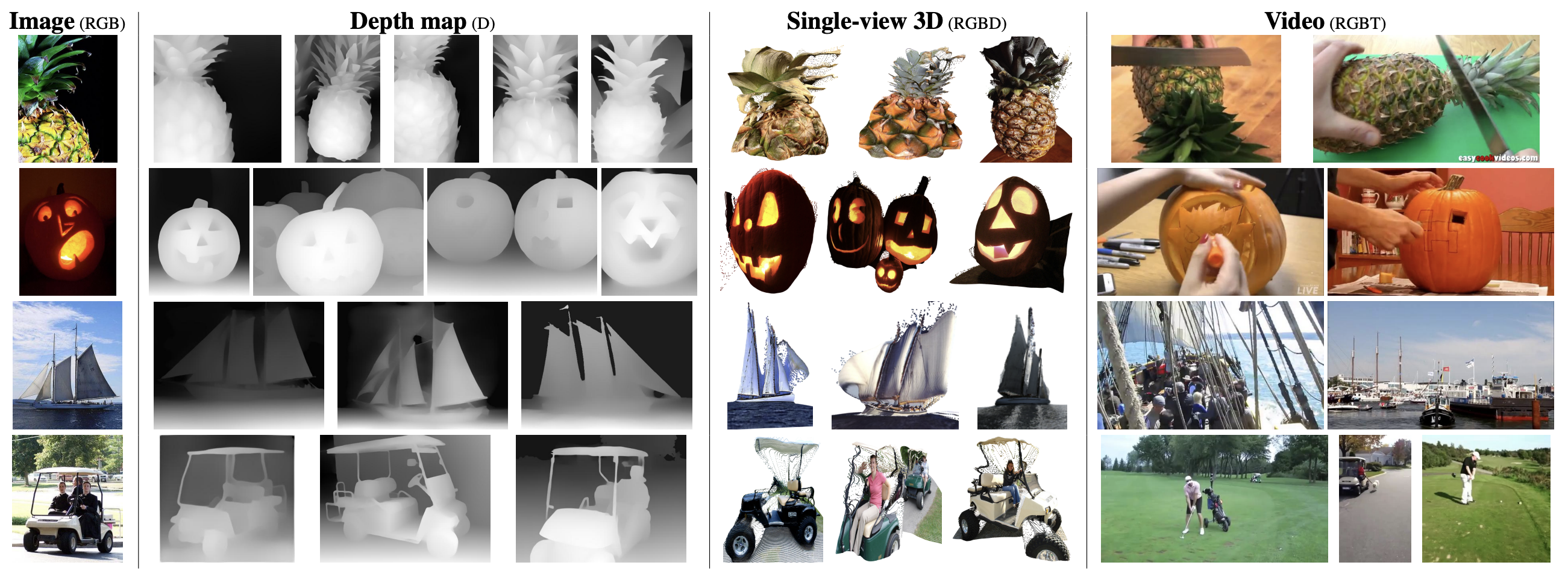

논문에서 제안하는 OMNIVORE model 은 (1) Image, (2) Video, (3) single-view 3D 를 다룸

- Method

Input Patches

Input 을 모두 $\mathbf{X} \in \mathbb{R}^{T \times H \times W \times C}$ 의 4D tensor 로 표현

Image: $\mathbf{I} \in \mathbb{R}^{1 \times H \times W \times 3}$

Video: $\mathbf{V} \in \mathbb{R}^{T \times H \times W \times 3}$

3D Image: $\mathbf{D} \in \mathbb{R}^{1 \times H \times W \times 4}$

Model Architecture

$t \times h \times w \times c$ sized patch into $d$ size embedding

All ViT architectures are available - Swin transformer is used in this paper

Two positional encoding - Spatial dimension, temporal dimension

$f(\mathbf{X})=\boldsymbol{\Phi}$

Dataset-specific linear classification layers on top of $\boldsymbol{\Phi}$

- Experiment

TBU

- Discussion

별 다른 내용 없다고 느껴짐..

- Reference

[1] Girdhar, Rohit, et al. "Omnivore: A single model for many visual modalities." CVPR 2022 [Paper link]